Meta llama 的集成环境可以通过这个ollama项目进行安装,在mac和linux上面非常简单,现在windows 版本也是预览版本,可以尝试安装。

下载模型后就可以直接通过命令行进行执行,非常快速。下载模型时可能初始速度比较慢,但后面越下载越快。

选择合适的客户端进行安装。

通过以下程序查看如何启动 meta 的llama3

https://ollama.com/library/llama3

Meta AI官网,可以查看 Meta 的llama 3的介绍。

https://ai.meta.com/blog/meta-llama-3/

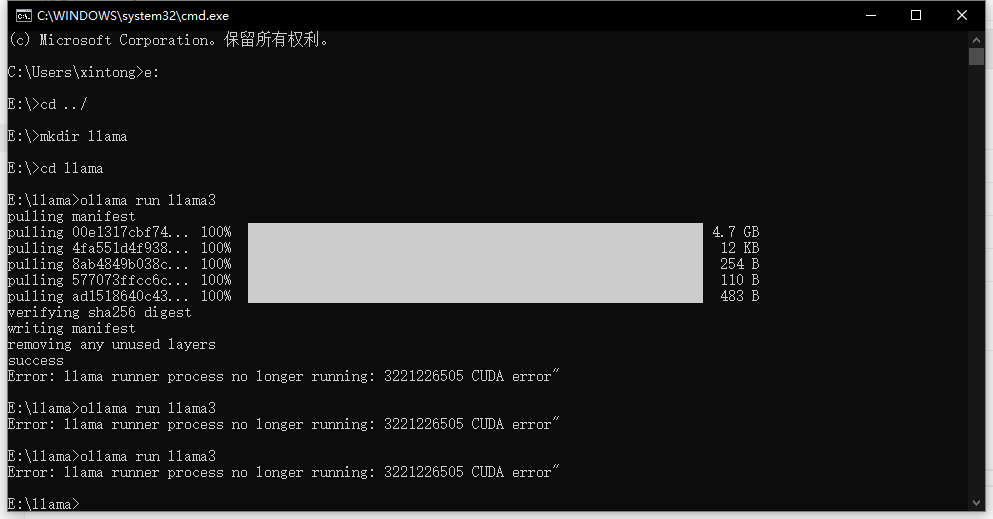

这是我的安装命令,一句命令行就能执行起来,但我的windows 机器还是性能环境不行,只跑通了一次,其他时候跑不通。

开始运行出错:

https://github.com/ollama/ollama/pull/3850

最终运行成功过一次:

如果你还想继续做web的UI化,基于 Ollama项目的UI项目也可以参考部署一下, Openwebui 项目可以链接各种不同的模型,可以搞一些不同的内容。

Open-webui 的项目地址

https://github.com/open-webui/open-webui

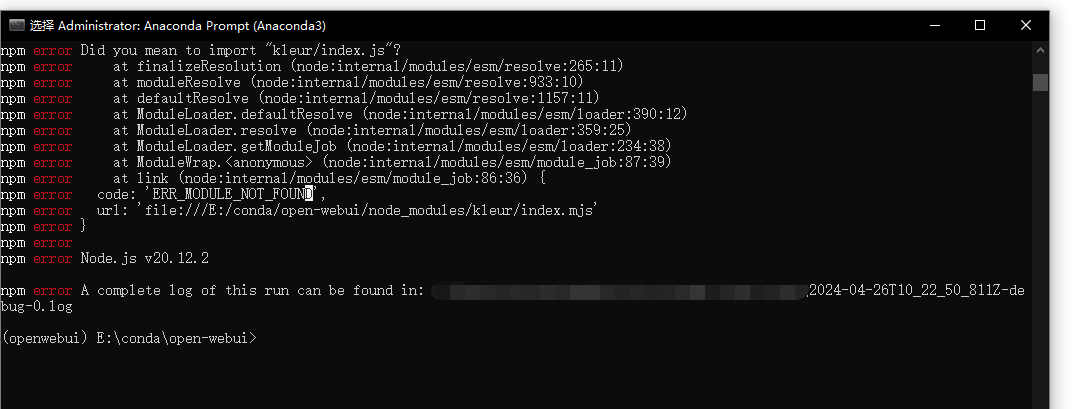

我部署还是遇到了坑,在自己的机器上部署不起来。第一步安装openwebui都没起来,看来还是要搞docker比较好。

其他使用:

使用Ollama和OpenWebUI在CPU上玩转Meta Llama3-8B

来自 <https://tonybai.com/2024/04/23/playing-with-meta-llama3-8b-on-cpu-using-ollama-and-openwebui/>